- WIADOMOŚCI

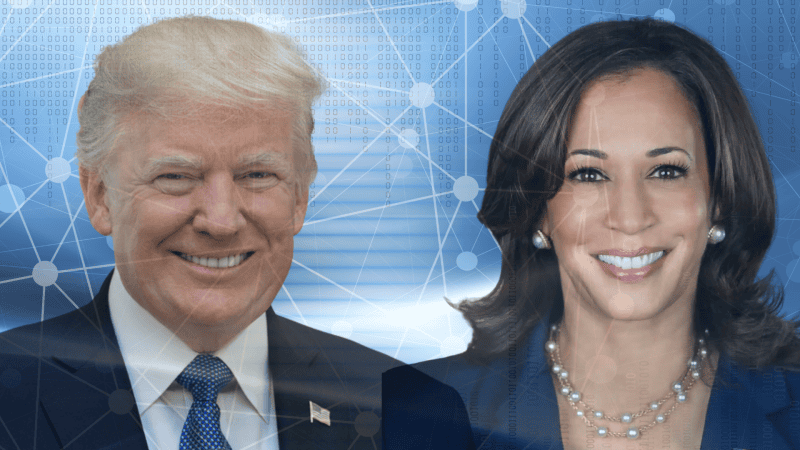

Jak działają deepfake’i polityczne? "Poligon doświadczalny"

Zmanipulowane lub wygenerowane przy pomocy AI filmy, zdjęcia i dźwięki z politykami i polityczkami w rolach głównych, były zmorą przed wyborami do Parlamentu Europejskiego. Z podobnym problemem mierzą się obecnie Stany Zjednoczone – na kilka miesięcy przed wyborami prezydenckimi. O skuteczne sposoby walkę z dezinformacją polityczną zapytaliśmy Adama Majchrzaka starszego analityka Stowarzyszenia Demagog.

Autor. whitehouse.gov / Canva

Dezinformacja przedwyborcza nie jest niczym nowym. Jednak w dobie tanich narzędzi AI i rozpowszechnienia mediów społecznościowych zjawisko to staje się coraz bardziej niebezpieczne.

„Wydaje się nam, że social media są miłym i przyjaznym miejscem, w którym możemy się zrelaksować i skorzystać z rozrywki, ale niestety nie do końca tak jest. Obecnie dosłownie jest to śmietnik informacyjny, do którego trafia wszystko i od nas zależy, czy poradzimy sobie z odpowiednią segregacją” – komentuje w rozmowie z CyberDefence24.pl Adam Majchrzak, starszy analityk Stowarzyszenia Demagog.

Autor. demagog.org.pl

„Dezinformacja pomaga populistycznym partiom"

Nasz rozmówca zaznacza, że problem jest palący, ponieważ fake newsy i deepfake’i mogą wpływać na decyzje wyborców i ich preferencje oraz polaryzować społeczeństwo. „Obok pojawia się też ryzyko, że fałszywe informacje mogą podważać zaufanie do instytucji demokratycznych i wyborów, a tym samym obniżą frekwencję. Do tego z badań z 2018 roku wynika, że mogą one sprzyjać populistycznym partiom i politykom” – wylicza Majchrzak.

Problem ukazuje niedawny wpis Elona Muska. Kontrowersyjny milarder udostępnił deepfake’a z Kamalą Harris, ale nagranie nie zostało oznaczone jako wygenerowane przez sztuczną inteligencję. Przy wpisie nie pojawiły się też notki społeczności. W efekcie część odbiorców mogła po prostu uwierzyć w spreparowane wideo.

W kolejnym wpisie Musk nazwał materiał „parodią” - tym słowem próbując usprawiedliwić oczywisty atak na wiceprezydentkę USA, który stanowi jednocześnie dezinformację przedwyborczą. O sprawie pisaliśmy na naszych łamach.

This is amazing

— Elon Musk (@elonmusk) July 26, 2024

pic.twitter.com/KpnBKGUUwn

Kto tworzy deepfake'i polityczne?

Amerykańscy urzędnicy śledzący kampanie dezinformacyjne twierdzą, że wydali więcej ostrzeżeń kandydatom politycznym, liderom rządowym i innym osobom, które są celem ataków zagranicznych grup w ostatnich miesiącach, w związku z próbami wpłynięcia na wyniki nadchodzących wyborów prezydenckich – donosi agencja Associated Press.

Wybory odbędą się 5 listopada 2025 roku, natomiast ostrzeżenia są wydawane od jesieni 2023. Jednak nie tylko obce państwa, takie jak Rosja czy Chiny mają interes w tym, żeby zakłócać proces wyborczy w Stanach Zjednoczonych. Z takich metod korzystają też partie polityczne, choć oczywiście nigdy oficjalnie nie przyznają się do tego.

Testowanie deepfake'ów

„Obecnie mamy do czynienia z poligonem doświadczalnym - politycy z różnych ugrupowań oraz podmioty odpowiedzialne za zewnętrzne ingerencje w wybory mogą testować, do czego i w jakim zakresie deepfake’i mogą się przydać” – tłumaczy Majchrzak.

Ekspert wskazuje, że w Polsce podobny proces miał miejsce przy okazji ostatnich wyborów parlamentarnych, w 2023 roku. Podczas kwietnikowych wyborów samorządowych Nagranie jednego z kandydatów na prezydenta miasta - Łukasza Schreibera, w którym przedstawiał obietnice wyborcze, zostało zmanipulowane. Na deepfake’u polityk zapowiadał cykliczne walki kobiet MMA, które miałyby się odbywać na Starym Rynku w Bydgoszczy.

Wykorzystanie sztucznej inteligencji do szerzenia dezinformacji było też widoczne w Polsce i za granicą podczas czerwcowych eurowyborów.

„Tym razem odbywa się to w amerykańskiej infosferze, gdzie możemy znaleźć liczne przykłady - mniej lub trudniej rozpoznanych - deepfake«ów z Joe Bidenem, Kamalą Harris i Donaldem Trumpem” – wylicza ekspert.

Kto jest podatny na dezinformację?

Zapytaliśmy analityka Stowarzyszenia Demagog, kto jest najbardziej podatny na deepfake’i polityczne. „Każdy z nas jest narażony na dezinformację związaną z wyborami, choć najbardziej narażone grupy to osoby o niskich kompetencjach medialnych i cyfrowych” – ocenia Majchrzak. Jak zaznacza ekspert - takich osób jest sporo, ponieważ nie chodzi tu o zwykłą umiejętność obsługi komputera czy telefonu, lecz o odpowiedzialne podejście i krytyczny odbiór wobec docierających do nas informacji.

„Pamiętajmy, że do wyborców bardzo przemawia negatywny przekaz, a każdy deepfake ma potencjał do tego, by dyskredytować wizerunek polityka czy wywoływać skandal obyczajowy, a w konsekwencji wzmocnić poparcie innego kandydata” – podkreśla nasz rozmówca.

Uważam, że na razie o wiele więcej szkód mogą wyrządzić klasyczne fake newsy, ponieważ ich stworzenie i rozpowszechnianie jest łatwiejsze, szybsze i przede wszystkim bardziej subtelne niż typowy deepfake, który nadal pozostaje łatwy do weryfikacji dla uważniejszego odbiorcy.

Adam Majchrzak, starszy analityk Stowarzyszenia Demagog

Walka z deepfake'ami

Wybory prezydenckie w USA mogą okazać się kluczowe w kontekście walki z politycznymi deepfake’ami. „Cykl wyborczy wystawi na próbę granice tych nowych technologii, odporność ewoluującej świadomości medialnej społeczeństwa i możliwości regulatorów, którzy walczą o utrzymanie kontroli nad sytuacją” – ocenia portal The Verge.

W Stanach Zjednoczonych coraz więcej mówi się o potrzebie prawnej regulacji narzędzi sztucznej inteligencji, w tym kwestii deepfak«ów i dezinformacji. Do Senatu trafiło nawet kila ustaw, m.in. w sprawie ochrony wyborców przed oszustwami z użyciem AI, czy - 31 lipca – o zamówieniach publicznych, która także regulowałaby omawiane problemy. Jednak do ich uchwalenia jeszcze długa droga – nie wiadomo, czy uda się to zrobić przed wyborami.

W Unii Europejskiej kwestie te reguluje akt o sztucznej inteligencji, który wszedł w życie 1 sierpnia. Nowe prawo nakłada obowiązek na dostawców i użytkowników mediów społecznościowych odpowiednie oznaczanie treści wygenerowanych przez AI, co ułatwi walkę z dezinformacją.

Prawo, edukacja i profilaktyka

Adama Majchrzak przypomina, że oznaczanie treści GenAI to tylko jedna z metod. „Z pewnością jest to jedna z możliwych i skutecznych opcji, a wielkie platformy powinny przyśpieszyć działania, które umożliwią sprawne oznaczanie takich treści. Jednak potrzebujemy kompleksowych rozwiązań - tak samo rządy państw działać i poświęcać więcej uwagi edukacji medialnej już na poziomie szkoły podstawowej, by w przyszłości ludzie byli choć trochę bardziej przygotowani na nowoczesne zagrożenia” – komentuje ekspert w rozmowie z naszą redakcją.

Według analityka Demagoga młodzi powinni być uczeni, jak rozpoznawać fotomontaże, deepfake’i czy cheapfake’i (proste przeróbki wideo, które nie wymagają dużego nakładu sił i nowych technologii). Majchrzak poleca wszystkim korzystanie z narzędzi do weryfikacji deepfake«ów, które są już powszechne i często dostępne za darmo.

„Do tego warto świadomie obcować z deepfake’ami, by nauczyć się ich rozpoznawania poprzez identyfikację charakterystycznych błędów, które zawierają” – tłumaczy. Cechy charakterystyczne w przypadku wideo to m.in. nienaturalne ruchy twarzy i palców. Więcej na ten temat można przeczytać TUTAJ.

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?