- WIADOMOŚCI

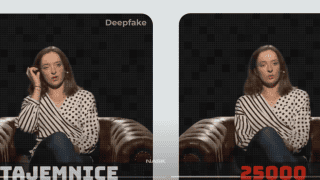

Deepfake. Oszuści podszywają się pod dziennikarzy, polityków, sportowców

Deepfake to rosnący problem, oszuści coraz częściej wykorzystują wideo czy audio wygenerowane przez sztuczną inteligencję jako metodę wyłudzania danych i pieniędzy, podszywając się pod znane osoby. W ciągu ostatniego pół roku bazowali na wizerunku 121 znanych osób, z czego aż 32 proc. stanowiło manipulację głosem i wizerunkiem dziennikarzy - wynika z analizy NASK.

Autor. Zanyar Ibrahim/ Unsplash

W połowie maja br. informowaliśmy o ostrzeżeniu przed falą fałszywych materiałów wideo, w których cyberprzestępcy podszywają się pod znane osoby, np. prezydenta Andrzeja Dudę, Roberta Lewandowskiego czy prezesa Inpost Rafała Brzoskę.

W mediach społecznościowych stają się powszechne reklamy fałszywych inwestycji. Podobnie pojawiają się zdjęcia i fikcyjne artykuły, podszywające się pod serwisy informacyjne, które mają opisywać rzekomy schemat „cudownej” i „szybkiej” inwestycji w rzeczywistości będącej oszustwem, o czym więcej możecie przeczytać w tym tekście.

Upowszechnienie narzędzi sztucznej inteligencji powoduje, że cyberprzestępczość wchodzi na wyższy poziom, a to, co widzimy, słyszymy i o czym czytamy w sieci wymaga krytycznego myślenia i umiejętności odróżnienia prawdy od fikcji.

„Nie wierz bezkrytycznie w żaden film, który zobaczysz. Nie wierz nawet wtedy, gdy swoim własnym głosem, połączonym z właściwymi ruchami ust, wypowiada się na nim osoba publiczna, która cieszy się autorytetem” – mówi Ewelina Bartuzi-Trokielewicz z Pionu Sztucznej Inteligencji w NASK (nasz wywiad z ekspertką możecie przeczytać tutaj.

Zobacz też

Oszustwa z wizerunkiem znanych osób

Jak pokazuje najnowsza analiza NASK, niestety oszuści masowo wykorzystują wizerunki znanych osób, by manipulować odbiorcami i zwiększyć wiarygodność przekazywanych przez siebie treści.

Z badania wynika, że tylko w ciągu ostatniego pół roku bazowano na wizerunkach 121 osób publicznych: dziennikarzy, sportówców, polityków do generowania deepfake«ów.

„To pokazuje dynamikę działań cyberprzestępców i różnorodność oszustw, dopasowanych do innych grup odbiorców” – uważa Joanna Gajewska z zespołu, który w NASK zajmuje się analizą deepfake.

Autor. NASK/ materiały prasowe

Najbardziej narażeni dziennikarze

Na bazie danych zebranych przez NASK oraz ekspertów KNF można wysnuć wniosek, że najczęściej przestępcy bazują na wizerunku dziennikarzy - tak było w 32 proc. przypadków.

Chodzi zarówno o oszustwa, kiedy redaktor lub redaktorka namawiają do inwestycji finansowej (np. Piotr Kraśko, Danuta Holecka czy Wojciech Cejrowski) lub zakupu lekarstwa (np. Monika Olejnik, Paulina Smaszcz), ale też - w fałszywym spocie - przeprowadzają wywiad z inną osobą, której wizerunek bezprawnie użyto np. z politykiem.

Najczęściej cyberprzestępcy kradną także wizerunek i głos polityków (21 proc.), biznesmenów (11 proc.), dychownych (7 proc.), influencerów (5 proc.) i sportowców (5 proc.) czy lekarzy (4 proc.).

Od początku 2024 roku w oszustwach, które wystąpiły na platformach: X, Facebook, YouTube, TikTok pojawiły się (poza wskazymi wyżej) m.in. takie osoby jak prezes Inpost Rafał Brzoska (o tym oszustwie pisaliśmy w tym materiale, Marek Czyż, Krzysztof Cugowski, Agata Duda, Katarzyna Dowbor, Ewa Drzyzga, Janusz Gajos, Szymon Hołownia, Jarosław Kaczyński, Aleksander Kwaśniewski, Antoni Macierewicz, Elon Musk, Maryla Rodowicz, Bogdan Rymanowski, Rafał Trzaskowski czy Mark Zuckerberg.

Autor. materiały NASK - YouTube

Jak się chronić?

NASK przypomina, że podstawą jest edukacja. O tym, jak rozpoznać deepfake pisaliśmy w tym tekście. Trzeba wziąć pod uwagę, że rozwój narzędzi sztucznej inteligencji będzie wymagał coraz większych umiejętności odróżnienia czy dany materiał jest prawdziwy, czy został wygenerowany przy pomocy AI. Stąd nauka krytycznego podejścia do źródeł informacji będzie niezbędna.

Zobacz też

Warto także pamiętać, by zgłaszać fałszywe treści do CERT Polska na adres: incydent.cert.pl. Oszustwa deepfake dodatkowo można wysyłać na maila [email protected], gdzie zespół ekspertów z Pionu Sztucznej Inteligencji NASK we współpracy z CERT Polska i CSIRT KNF pracuje nad narzędziem do ich automatycznej detekcji (również bazującym na AI).

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?