- WIADOMOŚCI

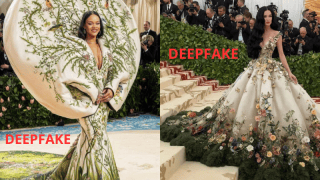

Ważne ostrzeżenie: rośnie liczba deepfake'ów z wizerunkiem osób publicznych

Deepfake’i w sieci są coraz powszechniejsze. Ich celem jest oszukanie odbiorców i - poza wprowadzeniem w błąd - najczęściej namówienie na fałszywe inwestycje. NASK ostrzega przed falą fałszywych materiałów wideo, w których cyberprzestępcy podszywają się pod znane osoby, np. prezydenta Andrzeja Dudę, Roberta Lewandowskiego czy prezesa Inpost Rafała Brzoskę.

Materiały wideo stworzone przy pomocy algorytmów sztucznej inteligencji - coraz tańsze i łatwiejsze do wykonania - mogą być używane zarówno do dobrych, jak i złych celów. To od intencji ich twórcy, a także oznaczenia takiego materiału zależy czy odbiorca nie zostanie zmanipulowany.

Jednak oszuści także korzystają z możliwości technologii i coraz częściej decydują się na stworzenie fałszywek przy pomocy AI. W mediach społecznościowych stają się powszechne reklamy fałszywych inwestycji, w których wykorzystywany jest wizerunek np. prezydenta Andrzeja Dudy, minister zdrowia Izabeli Leszczyny, piłkarza Roberta Lewandowskiego, prezesa InPost Rafał Brzoski, influencera Buddy czy premiera Donalda Tuska.

Podobnie pojawiają się zdjęcia i fikcyjne artykuły, podszywające się pod serwisy informacyjne, które mają opisywać rzekomy schemat „cudownej” i „szybkiej” inwestycji w rzeczywistości będącej oszustwem, o czym więcej możecie przeczytać w tym tekście.

Przykłady deepfake«ów można zobaczyć w poniższym materiale:

Schemat taki, jak zawsze

NASK ostrzega, że deepfake«ów z wykorzystaniem wizerunku znanych osób jest coraz więcej. Chodzi o namówienie w materiałach do rzekomo „wyjątkowo korzystnych” inwestycji finansowych. Do tego automatycznie wygenerowany głos, który prezentuje wybrany, fałszywy przekaz, w coraz większym stopniu spójny z ruchami ust i gestykulacją.

Od początku maja pojawiło się wiele nowych oszustw wykorzystujących technologię deepfake i wizerunki znanych osób. Wyglądają one coraz bardziej wiarygodnie.

NASK PIB

Instytucja zaznacza, że na kradzież wizerunku (a także głosu) narażeni są wszyscy ci, którzy spełniają dwa kryteria: są znani i cieszą się (w określonej grupie) społecznym autorytetem. Mogą to być często politycy, biznesmeni, celebryci. Wskazuje, że często fałszywe treści przypominają „przekaz programu informacyjnego”.

„Taki zabieg pokazuje, jak technologia deepfake może być wykorzystana do tworzenia kompleksowych, przekonujących, choć fałszywych narracji, które na pierwszy rzut oka mogą wydawać się autentyczne” - czytamy.

Ewelina Bartuzi-Trokielewicz, kierująca w NASK Zespołem Analizy Deepfake zaznacza, że łatwość, z jaką można stworzyć fałszywe materiały audiowizualne, zwiększa ryzyko manipulacji i dezinformacji.

„Dlatego istotne jest zwiększenie świadomości społecznej na temat rozwoju i możliwości technologii generowania treści syntetycznych. Użytkownicy mediów społecznościowych powinni ostrożnie podchodzić do treści wideo, które wydają się niezweryfikowane lub podejrzane. Dotyczy to zwłaszcza tych materiałów, które mają potencjalny wpływ na publiczne postrzeganie znaczących postaci i instytucji” – ocenia.

Nasz wywiad z ekspertką możecie przeczytać tutaj.

Jak można bronić się przed deepfake?

O tym, jak rozpoznać deepfake pisaliśmy na łamach CyberDefence24.pl między innymi w tej analizie Demagoga. Chodzi przede wszystkim o analizę wideo pod kątem audiowizualnym: weryfikacji mimiki twarzy, ruchu ust, rozmazania poszczególnych elementów ciała, nienaturalnych dłoni czy sztucznie brzmiącego głosu, bez emocji i intonacji.

Dodatkowo NASK przestrzega, aby zwrócić uwagę na treść przekazu: często ma budzić emocje u odbiorców i skłonić do natychmiastowego działania. To często stosowane zasady socjotechniki:

- wykorzystanie autorytetu i zaufania;

- "ograniczona w czasie" dostępność produktu/ usługi;

- "wyjątkowość" oferty;

- odwoływanie się, bazowanie na emocjach;

- obietnica szybkiego zysku;

- ponaglanie do działania "tu i teraz";

- adresowanie przekazu do konkretnej grupy (szczególnie podatnej na określoną manipulację);

- podkreślenie przynaleźności do "elitarnej" grupy i "wybrańców", którzy mogą skorzystać z oferty.

Gdzie zgłaszać deepfake?

Przypominamy, że fałszywe SMS-y, w tym materiały materiały filmowe wykorzystujące deepfake można przekazać do CERT Polska na numer 8080 (klikając: „przekaż dalej”) lub przez stronę: incydent.cert.pl.

Natomiast materiały deepfake zawierające treści przedstawiające seksualne wykorzystywanie osób małoletnich trzeba najszybciej zgłosić do zespołu Dyżurnet.pl.

Z kolei treści, które wykorzystują technologię deepfake można też przesyłać (z linkiem) na adres: [email protected].

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?