- ANALIZA

#CyberMagazyn: Rozwój AI to rozwój dezinformacji. Prognozy z globalnego szczytu

Sztuczna inteligencja może być umyślnie wykorzystywana do szerzenia fałszywych informacji. Podczas pierwszego globalnego szczytu dotyczącego bezpieczeństwa AI rozważano, jakie zagrożenia czają się za rogiem.

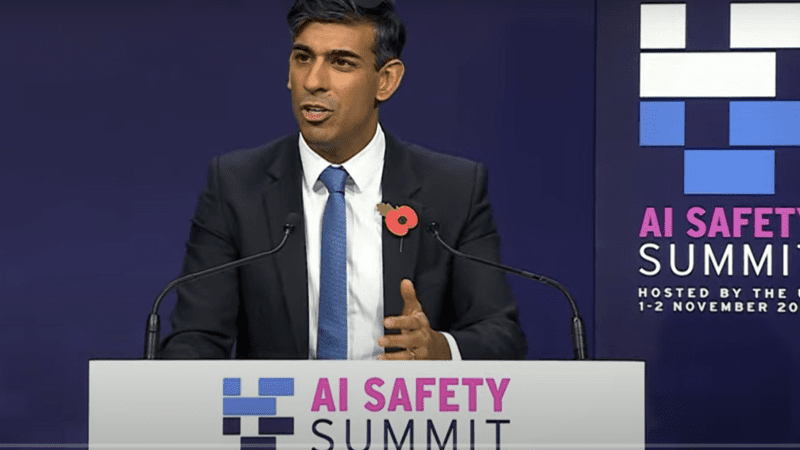

Autor. AI Safety Summit / screen YouTube

„Przestępcy mogą nadużywać sztucznej inteligencji do cyberataków, do dezinformacji, do oszustw finansowych, a nawet do wykorzystywania seksualnego dzieci” – ostrzegł premier Wielkiej Brytanii Rishi Sunak na tydzień przed globalnym szczytem na temat bezpieczeństwa AI.

W dniach 1–2 listopada w angielskim Bletchley odbył się szczyt AI Safety Summit, podczas którego politycy, reprezentanci firm technologicznych, eksperci i naukowcy dyskutowali o ryzykach związanych z rozwojem sztucznej inteligencji. Wśród zidentyfikowanych zagrożeń znalazła się dezinformacja, którą zaliczono do kategorii szkód społecznych oraz nadużyć.

W deklaracji ze szczytu przedstawiciele państw wyrazili zaniepokojenie wykorzystaniem dużych modeli językowych (ang. Large Language Models) do szerzenia dezinformacji. Są to modele, które wykorzystują głębokie uczenie maszynowe do tworzenia treści zgodnie z wprowadzanym zapytaniem (np. ChatGPT). W czym przejawia się jednak wspomniane „zaniepokojenie”? O jakich zagrożeniach mowa? Z pomocą przychodzi raport powstały na potrzeby tego wydarzenia.

Dezinformacja będzie coraz tańsza

Już teraz, aby nabyć fałszywe konto w mediach społecznościowych, wystarczy zapłacić 1 euro. Stąd też przyjęło się uważać, że dezinformacja jest tania. Szczególnie dla podmiotów dysponujących milionowymi budżetami, takich jak popularna fabryka rosyjskich trolli – Internet Research Agency. Rozwój dużych modeli językowych może sprawić, że koszty szerzenia dezinformacji staną się jeszcze niższe. Część osób pracujących w fabrykach trolli straci posady, a w ich miejsce przyjdzie sztuczna inteligencja, np. wspomniany już ChatGPT.

Eksperci z Center for Security and Emerging Technology wyliczyli, że zastosowanie dużych modeli językowych do wygenerowania 10 mln wpisów na Twitterze pozwoliłoby zaoszczędzić 3 mln dolarów. Jest jedno „ale” – wrogie działania informacyjne nie mogą zostać wykryte. Jeśli tak by się stało, koszty kampanii wzrastają.

Zmniejszenie kosztów prowadzenia kampanii dezinformacyjnych pozwala nie tylko zwiększyć oszczędności dużym graczom, lecz także obniżyć koszty wejścia na ten niechlubny rynek. Oznacza to, że działania dezinformacyjne może podjąć więcej podmiotów (osób), które nie dysponują zasobnym portfelem.

Deepfake’i staną się coraz bardziej realistyczne

Już dzisiaj za pomocą sztucznej inteligencji można wytworzyć wirtualny klon popularnej osoby. Autorzy raportu przewidują, że deepfake’i będą coraz bardziej realistyczne do tego stopnia, że problem z ich identyfikacją mogą mieć eksperci.

Deepfake’i staną się coraz bardziej spersonalizowane. W sieci będzie można natrafić już nie tylko na wygenerowane przez AI zdjęcie papieża czy prezydenta Polski, ale też kolegi z pracy czy członka rodziny. Dojdziemy do sytuacji, w której to deepfake’i pójdą w kierunku personalizacji i mikrotargetingu.

Chaos informacyjny się pogłębi

Popularyzacja treści AI w internecie i mediach społecznościowych może prowadzić do trudności w odróżnienia prawdy od fałszu, a wskutek tego – ograniczenia chęci weryfikacji informacji.

Paradoksalnie coraz częstsze mogą okazać się sytuacje, w których uznamy daną treść za wytwór AI, podczas gdy będzie to prawdziwe zdjęcie lub wideo. Upowszechnienie sztucznej inteligencji to także ryzyko kontynuacji procesu erozji środowiska informacyjnego. Dlaczego? Wyszukiwarki internetowe są wyposażone w funkcje wspierane przez AI.

Przykładowo w Bingu można skorzystać z czatu wspieranego przez GPT-4. Użytkownicy mogą coraz częściej wyszukiwać informacje za pomocą tej funkcji, zaniedbując klasyczne wyszukiwanie, odsyłające do materiałów z mediów, które pełnią ważną rolę w weryfikacji fake newsów.

Co więcej, korzystając z Chatu GPT lub innego modelu istnieje ryzyko, że AI zaprezentuje nam sfabrykowane informacje niemające potwierdzenia w żadnym źródle. Są to tak zwane halucynacje sztucznej inteligencji.

AI zagrożeniem dla demokratycznych wyborów

Na jeszcze jedną kwestię uwagę zwrócili uczestnicy jednego z okrągłych stołów, który odbył się podczas AI Safety Summit. Zdaniem ministrów, treści generowane przez AI – głównie deepfake’i – stanowią zagrożenie dla demokratycznych wyborów. Ta hipoteza może zostać bardzo szybko zweryfikowana. W 2024 roku odbędą się m.in. wybory prezydenckie w Stanach Zjednoczonych oraz wybory do Parlamentu Europejskiego.

Unijne służby już teraz informują, że wykryły wzmożoną aktywność użycia AI do generowania treści. Zdaniem Agencji Unii Europejskiej ds. Cyberbezpieczeństwa, przyszłoroczne wybory mogą stać pod znakiem czatbotów napędzonych przez AI i deepfake’ów.

Dobrze, że prób ingerencji są świadomymi politycy, którzy wzięli udział w AI Safety Summit. Niewątpliwie dezinformacja może mieć źródła zewnątrzne. Niemniej, jak pokazuje raport uczonych z Oxfordu, dezinformacja może wywodzić się z wewnętrznych struktur w kraju, a jej źródłem są też rządy oraz partie polityczne.

Zobacz też

Walka z dezinformacją napędzaną przez AI

Dlatego w zwalczanie dezinformacji nie mogą być zaangażowane wyłącznie państwa, choć niewątpliwie ich pomoc jest ważna z punktu widzenie regulacji. W deklaracji ze szczytu nie padły jednak sformułowania, z których wynikałby wola ustanowienia międzynarodowego prawa z zakresu bezpieczeństwa AI.

Należy mieć nadzieję na mniej sformalizowaną współpracę na linii państwa – Big Tech, ponieważ na tych drugich też spoczywa odpowiedzialność w walce z dezinformacją napędzaną AI. 6 przewodnich firm z branży AI – Google DeepMind, Anthropic, OpenAI, Microsoft, Amazon oraz Meta – opublikowało na potrzeby szczytu zasady z zakresu bezpieczeństwa AI.

W kontekście dezinformacji ważne jest, iż firmy dostrzegają konieczność identyfikacji treści, wytworzonych przez sztuczną inteligencją za pomocą znaku wodnego (choć to podejście nie jest idealne), a także audytów danych, które pozwolą na ograniczenie generowania niedokładnych odpowiedzi przez duże modele językowe.

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?