- WIADOMOŚCI

„Odpowiedzialny rozwój” sztucznej inteligencji. Deklaracja gigantów

W dniach 21-22 maja odbywa się Szczyt Bezpieczeństwa AI (AI Safety Summit) w Korei Południowej. To drugie spotkanie - po szczycie w Bletchley Park - przedstawicieli rządów, firm i naukowców, którzy dyskutują nad bezpieczeństwem, etyką i odpowiedzialnością prac nad rozwojem sztucznej inteligencji. Co ustalono tym razem?

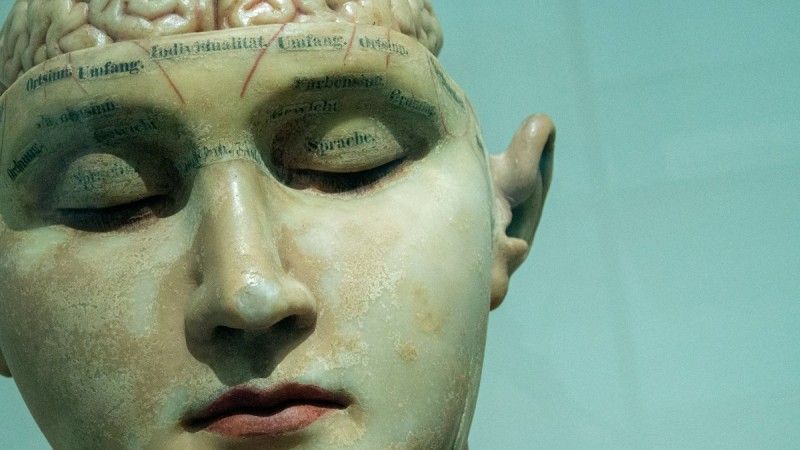

Autor. David Matos/ Unsplash

W listopadzie 2023 roku odbył się pierwszy w historii globalny szczyt dotyczący bezpieczeństwa AI - miał wtedy miejsce w Wielkiej Brytanii w Bletchley Park. O jego ustaleniach pisaliśmy między innymi w tym materiale.

Z kolei drugie spotkanie przedstawicieli rządów, wielkich firm technologicznych i środowiska naukowego skupionego wokół rozwoju sztucznej inteligencji odbywa się w dniach 21-22 maja br. w Seulu. Rząd Wielkiej Brytanii jest jego współgospodarzem, wraz z Republiką Korei.

Polski głos w sprawie AI

Jak informowaliśmy w ubiegłym tygodniu,w tegorocznym AI Safety Summit przedstawiciele polskiego rządu - wedle deklaracji - mają brać udział.

„Polska będzie obecna podczas AI Safety Summit i po miesiącach nieobecności będzie słyszany polski głos, który powie, że regulacje sztucznej inteligencji są ważne i pilne, ale dla nas największym priorytetem w tworzeniu tych regulacji jest to, aby powstały w szerokim porozumieniu” - mówił dr Dariusz Standerski, wiceminister cyfryzacji.

Szczyt bezpieczeństwa AI w Seulu

Szczyt AI Safety Summit w Seulu koncentruje się na tematach związanych z bezpieczeństwem sztucznej inteligencji i potencjale zaawansowanych modeli AI.

Co istotne, pierwszego dnia szczytu wiodące firmy technologiczne zobowiązały się do „dalszego bezpiecznego i odpowiedzialnego rozwoju technologii sztucznej inteligencji”. Chodzi łącznie o szesnaście firm, w tym m.in. OpenAI, Google, Microsoft, Meta, Amazon, Anthropic, Cohere, IBM, Inflection AI, Mistral AI, Samsung Electronics, xAi i Zhipu.ai (ta ostatnia to chińska firma), które zadeklarowały, że „priorytetem będzie bezpieczeństwo”.

Giganci, którzy pracują nad swoimi modelami sztucznej inteligencji oraz ich udoskonalaniem mają „oceniać ryzyko stwarzane przez ich pionierskie modele lub systemy, w tym przed ich wdrożeniem”, a „w stosownych przypadkach” przed i w trakcie szkolenia modelu.

Mają również zostać określone ramy i granice, kiedy państwa stwierdzą, że istnieje „poważne ryzyko” stwarzane przed model/ system, a jeśli nie zostanie to odpowiednio zgłoszone przez firmę, stanie się „niedopuszczalne”. Nie wyjaśniono jednak, w jaki sposób giganci zostaną pociągnęci do odpowiedzialności, gdyby nie wypełnili warunków deklaracji.

16 firm ma „zapewnić publiczną przejrzystość”, jeśli chodzi o realizację zobowiązań, poza sytucjami dotyczącymi np. ujawnienia informacji handlowych firmy.

OpenAI opublikowało aktualizację swoich praktyk bezpieczeństwa, w związku z deklaracją z Seulu.

Wśród gości mieli znaleźć się m.in. Elon Musk, czyli właściciel X (dawny Twitter), Tesli oraz pracujący nad rozwojem własnego modelu pod nazwą Grok (w startupie XAI); prezes Samsung Electronics Jay Y. Lee czy były dyrektor generalny Google - Eric Schmidt.

Ważna deklaracja

W czasie szczytu podpisanoważną deklarację na rzecz „bezpiecznej, innowacyjnej i inkluzywnej sztucznej inteligencji”.

„My, światowi przywódcy reprezentujący Australię, Kanadę, Unię Europejską, Francję, Niemcy, Włochy, Japonię, Republikę Korei, Republikę Singapuru, Wielką Brytanię i Stany Zjednoczone Ameryki, zebraliśmy się na szczycie AI w Seulu w dniu 21 maja 2024 r. i potwierdzamy nasze wspólne zaangażowanie we wspieranie międzynarodowej współpracy i dialogu na temat sztucznej inteligencji (AI) w obliczu jej bezprecedensowego postępu oraz wpływu na nasze gospodarki i społeczeństwa” - czytamy w dokumencie deklaracji.

Dalej przywódcy państw stwierdzili wspólnie, że „bezpieczeństwo, innowacja i inkluzywność w zakresie sztucznej inteligencji to wzajemnie powiązane cele i że ważne jest uwzględnienie tych priorytetów w międzynarodowych dyskusjach na temat zarządzania sztuczną inteligencją, w celu uwzględnienia szerokiego spektrum możliwości i wyzwań, jakie stwarza i może stwarzać projektowanie, rozwój, wdrażanie i wykorzystanie sztucznej inteligencji”.

Za istotną uznano także współpracę międzynarodową w dziedzinie nauki o bezpieczeństwie sztucznej inteligencji oraz zadeklarowano wsparcie dla utworzenia lub rozwoju instytutów bezpieczeństwa AI, programów badawczych i/lub innych odpowiednich instytucji, w tym organów nadzorczych.

„Wzywamy do wzmocnionej współpracy międzynarodowej w celu zwiększenia bezpieczeństwa, innowacyjności i inkluzywności sztucznej inteligencji, aby wykorzystać sztuczną inteligencję skoncentrowaną na człowieku do stawienia czoła największym wyzwaniom świata, ochrony i promowania wartości demokratycznych, praworządności i praw człowieka, podstawowych wolności i prywatności, niwelować lukę cyfrową pomiędzy krajami i w ich obrębie, przyczyniając się w ten sposób do poprawy dobrostanu ludzi, a także wspierać praktyczne zastosowania sztucznej inteligencji, w tym w celu realizacji celów zrównoważonego rozwoju ONZ” - stwierdzono również w Deklaracji Seulskiej.

Międzynarodowa sieć badawcza

Nowe porozumienie między 10 krajami oraz Unią Europejską na szczycie AI w Seulu zobowiązało państwa do współpracy międzynarodowej, by przyspieszyć postęp naukowy nad badaniami dotyczącymi bezpieczeństwa sztucznej inteligencji, a także utworzyć międzynarodową sieć badań nad bezpieczeństwem, na wzór Brytyjskiego Instytutu Bezpieczeństwa AI. Członkowie sieci to wedle deklaracji: Australia, Kanada, UE, Francja, Niemcy, Włochy, Japonia, Singapur, Korea Południowa, Wielka Brytania i USA. Mają oni promować wspólne stanowisko na temat bezpieczeństwa sztucznej inteligencji oraz dostosować je do standardów, badań i testów modeli.

„Nowo podpisana Deklaracja Seulska zobowiązuje przywódców do współpracy, aby upewnić się, że sztuczna inteligencja poprawia dobrostan ludzi i pomaga sprostać największym wyzwaniom świata w sposób godny zaufania i odpowiedzialny” - poinformował z kolei brytyjski rząd.

Premier Wielkiej Brytanii Rishi Sunak zaznaczył, że - aby uzyskać przewagę - muszą upewnić się, że (AI) jest bezpieczna.

„Dlatego cieszę się, że osiągnęliśmy dziś porozumienie w sprawie sieci instytutów bezpieczeństwa AI. Sześć miesięcy temu w Bletchley uruchomiliśmy brytyjski Instytut Bezpieczeństwa Sztucznej Inteligencji. Pierwszy w swoim rodzaju. Wiele krajów poszło w nasze ślady, a teraz, dzięki tej wiadomości - o sieci (instytutów), możemy nadal robić międzynarodowe postępy w zakresie bezpieczeństwa sztucznej inteligencji” - ocenił.

Wiadomo już, że kolejny szczyt bezpieczeństwa sztucznej inteligencji odbędzie się we Francji.

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?