- WIADOMOŚCI

Pierwszy robak wykorzystujący AI. Eksperci ostrzegają

Sztuczna inteligencja może być zarówno pożyteczna, jak i niebezpieczna. Do tego drugiego grona dołączyły właśnie robaki, które wykorzystują słabości AI i mogą działać bez wiedzy użytkownika.

Autor. Rodion Kutsaiev/Unsplash

Rozwoju asystentów AI nie da się już nie zauważyć. Wielu Polaków na swoich telefonach korzysta z Asystenta Google lub Siri; na komputerach z kolei Cortana została zastąpiona Copilotem od Microsoftu, który jest jednak powszechniejszy od swojej poprzedniczki.

Pierwszy robak korzystający z AI

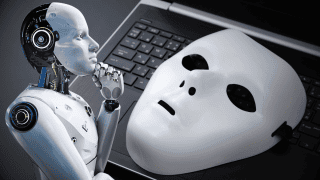

Okazuje się jednak, że pomimo postępu technologicznego, pozostały wciąż te same problemy. Z doniesień serwisu Arstechnica wynika, że ekspertom od cyberbezpieczeństwa udało się stworzyć pierwszego robaka komputerowego, który rozprzestrzenia się w oparciu o asystentów AI.

Za stworzenie robaka, nazwanego Morris II, odpowiadają eksperci z Cornell Tech: Ben Nassi, Stav Cohen i Ron Bitton. Nazwa odnosi się oczywiście do pierwszego robaka stworzonego przez Roberta Morrisa w 1988 roku. W odróżnieniu od swojego imiennika, Morris II nie wyrządził jednak żadnych niekontrolowanych szkód.

Niewinne polecenia, ale duże szkody

Eksperymenty odbyły się w izolowanym środowisku, na asystentach zdolnych do generowania tekstu, filmów oraz obrazów. Przetestowano dwa sposoby: w pierwszym - wiadomość e-mail wysłana na testową skrzynkę zawierała tekst z poleceniem dla asystenta AI. Ten przetwarzał polecenie i wysyłał je do modelu AI typu Gemini lub GPT-4. Efektem było jednak złamanie zabezpieczeń sztucznej inteligencji i kradzież danych z e-maili. Wygenerowana odpowiedź rozprzestrzeniała się następnie na inne komputery poprzez funkcję „odpowiedzi na daną wiadomość”.

Drugi sposób był nieco podobny do pierwszego – różnica polegała na tym, że polecenie dla asystenta zostało ukryte w obrazku wysłanym przez e-mail. Nakazywało ono przekazanie wiadomości dalej, do dowolnej liczby odbiorców. Z samych wiadomości można było również wydobyć wrażliwe dane – od numerów kart kredytowych do danych osobowych.

Zobacz też

Eksperci ostrzegają

Badacze nie tylko skonsultowali wyniki swoich badań z Google i OpenAI w sprawie zabezpieczeń odpowiednio Gemini i ChatGPT. Wystosowali również ostrzeżenie do całej branży sztucznej inteligencji, iż potrzebna jest zmiana w architekturze modeli, aby uniknąć prawdziwych robaków komputerowych wykorzystujących AI oraz potencjalnych szkód, jakie mogłyby spowodować.

/PM

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?