- WIADOMOŚCI

Wygenerować mowę za pomocą AI może każdy. Wystarczy kilkanaście godzin pracy

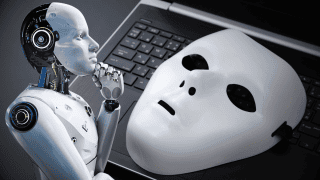

Problem oszustw z wykorzystaniem mowy wygenerowanej przez sztuczną inteligencję jest coraz poważniejszy. Mało kto zdaje sobie sprawę, że głos AI może przygotować każdy w swoim domowym zaciszu w zaledwie kilkanaście godzin.

Autor. Jacek Dylag/Unsplash

Dzisiaj obecność AI w domach pod postacią asystentów czy chatbotów nie jest już niczym nadzwyczajnym. O ile jednak w tym przypadku sztuczna inteligencja jest bardzo prosta do odróżnienia, tak już w kontekście reklam sytuacja tak klarowna nie jest.

Oszustwa na nowym poziomie

W listopadzie zeszłego roku na X (dawny Twitter) pojawiła się reklama, w której były prezydent Aleksander Kwaśniewski mówił o inwestowaniu oszczędności przez jedno z krajowych przedsiębiorstw – jego głos był oczywiście wygenerowany przez sztuczną inteligencję.

Scam wchodzi na wyższy poziom i korzysta z generatora głosu AI. pic.twitter.com/vezMmRe4e5

— Marian Baczał 🇵🇱🇱🇦 (@marian_baczal) November 2, 2023

Sporo osób było pod wrażeniem „wejścia oszustów na wyższy poziom”. Tymczasem okazuje się, że samodzielne przygotowanie podobnego materiału wcale nie jest trudne – przynajmniej dla osoby, która w wystarczającym stopniu zna program Audacity.

Śpiewająca metoda

Jedną z najprostszych metod jest wykorzystanie Singing Voice Conversion. Już sama nazwa wskazuje, że nie tylko obsługuje on „zwykłą” mowę, ale także i śpiew - SVC nie jest metodą przetwarzania tekstu na mowę, tak jak znana od lat Ivona czy Tacotron.

Tak jak przy każdej innej metodzie, SVC wymaga przygotowania audio postaci, której głos ma zostać wykorzystany w modelu – im więcej, tym lepiej. Swoje znaczenie ma również jakość – najbardziej przydatne będą nagrania studyjne, bez dźwięków w tle jak np. muzyka czy szumy.

Zobacz też

Obróbka – najbardziej żmudny etap

Każde nagranie mowy danej postaci należy podzielić w programie do obróbki dźwięku na osobne pliki w ten sposób, aby model mógł rozpoznać intonację czy przerwy na oddech. Im dłuższa dana wypowiedź, tym lepiej dla modelu podczas treningu – nagranie zawierające jedno-dwa słowa, trwające sekundę, pogorszy jakość modelu.

I to właśnie ten etap jest najbardziej żmudny ze wszystkich. Kolejnym jest już uruchomienie skryptu treningowego. Bardzo pomocna jest tutaj usługa Google Colab, dzięki której nawet mając komputer typowo biurowy, możliwe jest przygotowanie własnego AI z pomocą internetu.

Kilka godzin treningu

Trening danego modelu przy wykorzystaniu Google Colab może trwać kilka godzin. W przypadku darmowej wersji usługi, dane konto posiada limit wykorzystania zasobów - po jego wyczerpaniu, jeżeli dana osoba nie chce czekać 24 godziny na odnowienie limitu, może wykorzystać w tym celu inne konto. Wymaga to jednak uprzedniego przeniesienia wszystkich koniecznych plików. W przypadku treningu modelu na sprzęcie w domu, ograniczeń nie ma w ogóle.

Jeżeli model został wytrenowany w wystarczającym stopniu (postępy można odsłuchać w jednym z udostępnionych okienek), to można przygotować paczkę służącą do generowania wypowiedzi. Następnie w kolejnym skrypcie, tym razem odpowiedzialnym za sam proces generowania mowy, należy wskazać lokalizację modelu do wykorzystania i pobrać wszystkie potrzebne rzeczy.

Kluczem reference audio

Ostatnim elementem potrzebnym użytkownikowi jest reference audio, na podstawie którego model wygeneruje wypowiedź. Najpopularniejszym wyjściem jest nagranie własnej wypowiedzi albo wykorzystanie fragmentu jakiejś piosenki.

Ważnym elementem jest fakt, że model w trakcie generowania dźwięku stara się odtworzyć intonację oraz akcent z reference audio. Jeżeli więc będzie ono przygotowane niestarannie, to efekt końcowy może być niezadowalający dla użytkownika, ale jednocześnie jasną wskazówką, że wypowiedź została wygenerowana przez sztuczną inteligencję.

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?