- ANALIZA

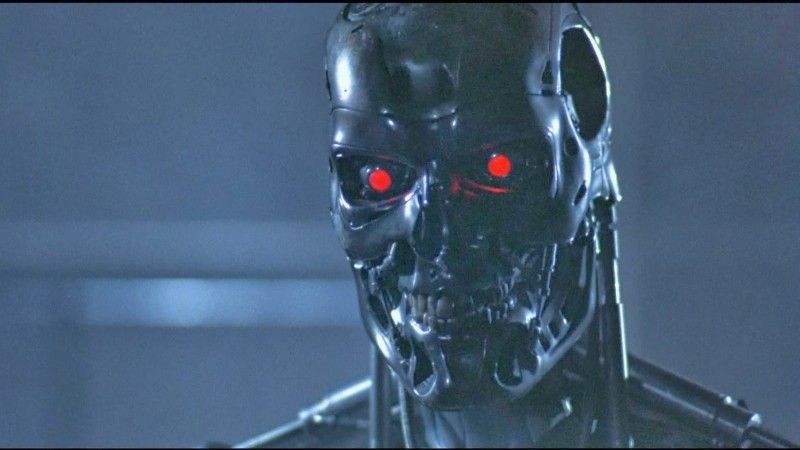

Groźna sztuczna inteligencja. Nadchodzi Terminator? [ANALIZA]

W ostatnim czasie coraz częściej dyskutuje się o kwestiach sztucznej inteligencji i potencjalnym zagrożeniu, które ona niesie. Wiele osób przywołuje scenariusz z filmu Terminator, gdzie inteligentne maszyny przejęły władzę nad światem. Taka wizja ma więcej wspólnego z filmem science fiction niż z rzeczywistością, ale sztuczna inteligencja już stanowi zagrożenie, zupełnie odmienne od tego przedstawionego w filmie.

Czym właściwie jest sztuczna inteligencja?

Sztuczna inteligencja w najbliższym czasie zmieni świat. Częściowo zmiana ta będzie pozytywna i może przysłużyć się ludzkości w takich sferach jak sektor zdrowotny, transport, lepsze planowanie miejskiej przestrzeni, ale jednocześnie może ona stanowić poważne zagrożenie, w szczególności w rękach grup terrorystycznych i przestępczych.

Obecnie obserwowany rozwój sztucznej inteligencji spowodowany jest głównie poprzez ekspotencjalny rozwój w dziedzinie technologii półprzewodnikowej. Cena mocy obliczeniowej, pamięci i przepływności łączy komunikacyjnych zmienia się wykładniczo w funkcji czasu i dostępny sprzęt pozwala na działanie w dużej skali algorytmów sztucznej inteligencji, które zostały opracowane ponad 40 lat temu. Za parę dolarów można stworzyć komputer, który posiada moc dawnych centrów obliczeniowych

Najczęstszym skojarzeniem związanym ze sztuczną inteligencją (AI) jest film Terminator, w którym myślące maszyny dokonują masowego ludobójstwa. AI może tak naprawdę przyjmować różne postacie od algorytmów wyszukiwarki Google, po cyfrowego asystenta SIRI, IBM Watson, kończąc na broni automatycznej.

Dzisiejszą sztuczną inteligencję określa się mianem ograniczonego lub słabego AI, która jest zdolna do wykonywania ograniczonej liczby zadań takich jak np. rozpoznanie twarzy, wyszukiwanie w Internecie czy też prowadzenie aut. Celem ostatecznym naukowców jest stworzenie ogólnej AI zwanej inaczej mocną AI lub AGI. Tzw. słaba AI uczy się tylko w wąskiej dziedzinie i jest w stanie pobić człowieka w specyficznych zadaniach takich jak np. granie w szachy czy rozwiązywanie zagadek, AGI będzie w stanie pokonać człowieka w każdym zadaniu. Pomimo, że wciąż daleko do stworzenia AGI, a według niektórych badaczy może to nigdy nie nastąpić do również słaba AI może stanowić potencjalne zagrożenie.

Dzięki mocy obliczeniowej komputery pokonują człowieka już nie tylko w szachy, ale także gry takie jak Go, które wymagają podejmowania decyzji w oparciu o „intuicję” i „doświadczenie”, a nie tylko zdolność logicznego myślenia. Sztuczna inteligencja wspiera nas w codziennym życiu powodując, że bardzo często nie musimy się wysilać i przestajemy od siebie wymagać. Dobrowolnie wyręczamy się maszynami i bezkrytycznie oddajemy w ich ręce swoje życie i swoją prywatność, uważając, że nie ma w tym nic złego. Biegamy z zegarkami, które chwalą nas za postępy w treningu, jeździmy samochodami, które właściwie nie wymagają od nas żadnych umiejętności, używamy telefonów i serwisów internetowych zamiast czytać książki – wykonując codzienne czynności zaczynamy chodzić na skróty. Człowiek przestaje być krytyczny wobec siebie i otaczającego świata oraz zabija w sobie głód poznania stając się powoli nieposkromionym konsumentem

Potencjalne zagrożenia

O zagrożeniu ze strony sztucznej inteligencji ostrzegali światowej sławy naukowcy i biznesmeni. Elon Musk, twórca Tesli i PayPala powiedział, że wyścig o uzyskanie przewagi na polu sztucznej inteligencji skończy się prawdopodobnie III wojną światową. Słynny brytyjski fizyk Stephen Hawking przestrzegał, że niepowstrzymany i nieregulowany rozwój sztucznej inteligencji może doprowadzić o stworzenia nowej formy życia i zastąpić ludzi. Wcześniej Hawking prognozował, że rozwój sztucznej inteligencji może doprowadzić do zniszczenia rasy ludzkiej, a ludzie muszą znaleźć sposób szybkiej identyfikacji zagrożeń związanych z AI zanim eskalują one na poziom zagrażający cywilizacji.

W kontekście zagrożeń płynących ze strony sztucznej inteligencji najczęściej wymienia się autonomiczne systemy uzbrojenia, które bez zgody człowieka będą mogły wybierać i eliminować cele. To właśnie w tym kontekście pojawia się najpopularniejsza wizja autonomicznych maszyn, które mogą zbuntować się przeciwko ludziom i rozpocząć masową wojnę jak w filmie Terminator. Siły zbrojne głównych mocarstw Rosji, Chin i Stanów Zjednoczonych intensywnie pracują nad wykorzystaniem sztucznej inteligencji do poprawy działania swojego wojska. Amerykanie eksperymentują z autonomicznym okrętem podwodnym, który jest w stanie śledzić wrogie jednostki na dystansie tysiąca mil a Chińczycy zademonstrowali inteligentne algorytmy pozwalające sterować rojem dronów. Wprawdzie daleko jeszcze do spełniania się wizji z filmu Terminator to Organizacja Narodów Zjednoczonych jak i Human Rights Watch apelują do polityków z całego świata żeby uchwalić traktat eliminujący taki rodzaj uzbrojenia. Tego typu apele mogą być skuteczne. Pracownicy Google w ten właśnie sposób zmusili firmę do wycofania się z projektu Maven, który zakładał ścisłą współpracę z Pentagonem przy rozwoju sztucznej inteligencji.

Zagrożenia związane z rozwojem sztucznej inteligencji może również podważyć społeczno-gospodarczy porządek obecnego świata. Inteligentne maszyny zastąpią nas w przyszłości w pracy zwiększając podział społeczny na kastę pracujących w zawodach wymagających zaawansowanej wiedzy i umiejętności oraz grupę osób, których praca została zautomatyzowana. Politycy będą musieli odpowiedzieć na to pytanie i w jakiś sposób zagospodarować masy bezrobotnych osób.

Omawiane wyżej zagrożenia związane ze sztuczną inteligencją to raczej kwestia 10 – 15 lat. Nie oznacza to jednak, że obecnie albo w najbliższej przyszłości nie będziemy musieli się mierzyć z zagrożeniem ze strony sztucznej inteligencji. W raporcie zatytułowanym: “The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation” autorzy przedstawiają potencjalne zagrożenia, które mogą wynikać z użycia sztucznej inteligencji w niedalekiej przyszłości i nie uciekają do wizji rodem z science-fiction. Zauważają, że przede wszystkim technologia ta zdecydowanie zmniejszy koszty przeprowadzania cyberataków, umożliwiając przestępcom automatyzację działań wymagających wcześniej ludzkiej pracy. Dobrym przykładem jest spearphising, gdzie próbuje się odpowiednio spreparować wiadomość, żeby ofiara uwierzyła, że jest ona prawdziwa. Wymaga to żmudnego przeszukiwania mediów społecznościowych w celu znalezienia informacji o ofierze, żeby tworzona fałszywa wiadomość w jak największym stopniu przypominała prawdziwą. Sztuczna inteligencja będzie mogła automatycznie wykonywać te czynności, znajdując informacje o ofierze i następnie generować fałszywe wiadomości. Można sobie również wyobrazić stworzenie chat botów, które będą na tyle realistycznie naśladowały człowieka, że będą w stanie udawać najlepszego przyjaciela. Przykładowo prowadzając normalny dialog mogą poprosić o login i hasło. Phising już obecnie stanowi bardzo groźne narzędzie często stosowane przez hakerów. Przyczynił się do ogromnego wycieku danych z ICloud w 2014 roku, wiadomości poczty elektronicznej Johna Podesty, szefa sztabu Hillary Clinton.

Sztuczna inteligencja doda też nowe wymiary do istniejących już zagrożeń. Przykładowo AI będzie mogła nie tylko w bardzo łatwy i szybki sposób generować fałszywe wiadomości tekstowe i mailowe, ale również w prosty sposób tworzyć fałszywe nagrania audiowizualne. Zostały przeprowadzone udane eksperymenty, w których sztuczna inteligencja była w stanie skutecznie naśladować czyiś głos po kilku minutach jego słuchania. W przeciągu 5 lat takie możliwości mogą być ogólnie dostępne, co daje duże możliwości przestępcom.

Zastosowanie sztucznej inteligencji może również wzmocnić już istniejące negatywne praktyki. Fałszywe filmy wideo i nagrania mogą zostać wykorzystane do manipulacji politycznej i propagandy, ale sztuczna inteligencja może również znaleźć zastosowanie w rozwiniętej i zaawansowanej inwigilacji. Takie rzeczy już mają miejsce w Chinach, gdzie systemy rozpoznawania twarzy oraz kamery śledzące ludzi wykorzystywane są do kontrolowania muzułmańskiej mniejszości Ujgurów. Sztuczna inteligencja może tutaj ułatwić kategoryzowanie ludzi ze względu na ich zachowania typując grupę osób stanowiących potencjalne zagrożenie. W przyszłości podobne systemy i to zdecydowanie na większą skalę będą wprowadzane w państwach autorytarnych, ale również demokracje mogą z nich korzystać w celu zwiększenia inwigilacji obywateli.

Sztuczna inteligencja może również zostać wykorzystana przez terrorystów. Przykładowo, można sobie wyobrazić scenariusz, gdzie terroryści ukrywają bombę w robocie-sprzątaczu i przemycają go do budynku ministerstwa. Następnie mogą wykorzystać automatyczne systemy naprowadzania w robocie, który pozwoli na zbliżenie się do danego polityka i wtedy dokonają eksplozji. W ten sposób terroryści wykorzystają nowe technologie i sprzęt bazujący na sztucznej inteligencji oraz wbudowane automatyczne funkcje takie jak właśnie namierzanie.

Mieliśmy już do czynienia z wykorzystaniem algorytmów sztucznej inteligencji do przeprowadzania ataków. Technologia zamiany twarzy została wykorzystana do utworzenia tzw. Deepfakes, gdzie twarze gwiazd Hollywood zostały wklejone do filmów pornograficznych bez ich zgody. W przyszłości może to być użyte do szantażowania ludzi i wyłudzania od nich pieniędzy. Na razie jednak nie ma żadnego potwierdzonego przypadku. Na szczęście w tym wypadku, mieliśmy również pozytywną reakcję ze strony platform internetowych, które bardzo szybko „zbanowały” takie treści skutecznie uniemożliwiając ich rozpowszechnienie. Niewątpliwe reakcja ta może napawać optymizmem.

Jak pokazują powyższe przykłady, sztuczna inteligencja już stanowi zagrożenie dla bezpieczeństwa w przyszłości może być tylko gorzej. W celu uniknięcia katastroficznego scenariusza, autorzy raportu “The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation” rekomendują podjęcie następujących działań:

- Naukowcy zajmujący się rozwojem sztucznej inteligencji powinni brać pod uwagę w swoich badaniach możliwość wykorzystania ich wyników w szkodliwy sposób;

- Politycy powinni przyswoić wiedzę i zrozumieć zagrożenia związane z rozwojem sztucznej inteligencji;

- Osoby pracujące nad tą nową technologią powinny blisko współpracować z ekspertami ds. cyberbezpieczeństwa w celu zrozumienia zagrożeń cyfrowych oraz lepszej ochrony systemów sztucznej inteligencji;

- Należy stworzyć etyczne zasady wykorzystania sztucznej inteligencji;

- Konieczne jest pobudzanie dyskusji, w którą zaangażowane będą środowiska naukowców, polityków, ale również etyków, biznesmenów oraz szeroko rozumiana opinia publiczna.

Na horyzoncie widać pozytywne oznaki realizacji wyżej wymienionych punktów. Ustawodawcy w Stanach Zjednoczonych coraz częściej dyskutują o tym problemie co pokazuje, że jest on dostrzegany. Widoczne jest coraz większe zaangażowanie rządu w dyskusję na te tematy. Dyskusja ta powinna być jednak dynamizowana w celu odpowiedzi na pytania o najbardziej krytyczne zagrożenia oraz praktyczne rozwiązania.

Paweł Pisarczyk podsumowuje, że brak krytycznego myślenia i zdziwienia wśród ludzi w połączeniu z ekspotencjalnym postępem w dziedzinie techniki, który jest głównym paliwem dla rozwoju sztucznej inteligencji sprawia, że wielu czołowych myślicieli świata stara się wzbudzić w nas refleksję, być może przerysowując na razie zagrożenia. Jeżeli ludzkość nie będzie mierzyć się z rzeczami wielkimi, jeżeli przestaniemy się rozwijać to wizje pokazane w filmach takich jak Terminator okażą się za kilkadziesiąt lat ponurą rzeczywistością. Tylko wtedy okaże się, że refleksja przyjdzie zbyt późno. Dlatego nie możemy trywializować postępu w dziedzinie sztucznej inteligencji, mówiąc, że na razie rozpoznaje obrazy, albo pozwala coś lepiej przewidywać.

Pisząc te słowa otrzymałem od swojego telefonu informację, że stworzył dla mnie wspomnienie pt. „Lata lecą” – zebrał moje zdjęcia i zrobił z nich film. Tak czas ucieka, wiem o tym i jestem dumny, że nie marnowałem czasu, ale nie chcę, żeby urządzenie serwowało mi taką papkę. Nie chce, by ktoś lub coś za mnie decydowało! Na razie jest to z pozoru niewinne, ale może okazać się, że wkrótce mój dom uzna, że nie mam prawa z niego wychodzić, bo jestem chory, a mój samochód nie pozwoli mi jechać tam gdzie chcę, bo dojdzie do wniosku, że jestem zbyt zdenerwowany. Nie pozwólmy na taki rozwój sztucznej inteligencji i nie pozwólmy na to, żeby maszyny stawały się coraz „mądrzejsze”, a człowiek zatracał umiejętność samodzielnego myślenia, czyli to co stanowi naszej o wyjątkowości

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?