- WIADOMOŚCI

Facebook rozwija projekt Ego4D. Uczy SI rozumienia świata z naszego punktu widzenia

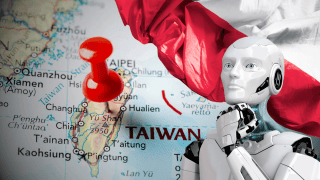

Facebook wraz z kilkunastoma ośrodkami naukowymi rozpoczął projekt o nazwie Ego4D. Ma on nauczyć systemy sztucznej inteligencji lepszego rozumienia świata widzianego z perspektywy pierwszej osoby. Dzięki temu w przyszłości SI ma lepiej pomagać ludziom w codziennym życiu.

Facebook ogłosił rozpoczęcie projektu badawczego Ego4D, którego celem jest uczenie sztucznej inteligencji percepcji egocentrycznej, czyli opartej na treściach audiowizualnych, nagranych z perspektywy pierwszej osoby.

Według zapowiedzi, firma przedstawi w przyszłości możliwości komercyjnego wykorzystania tej wiedzy do tworzenia rozwiązań AR/VR i robotyki, a w środowisku akademickim do rozwijania systemów SI, które będą lepiej rozumiały świat z punktu widzenia jednostki.

Nauka dla SI

Jak wyjaśnia FB we wpisie na blogu, większość treści audiowizualnych w internecie stanowiących materiał szkoleniowy dla systemów wizji komputerowej (CV) przedstawia rzeczywistość z perspektywy trzecioosobowej.

Tymczasem SI, która rozumie i wchodzi w interakcje ze światem z perspektywy pierwszej osoby, może zapoczątkować nową erę immersyjnych doświadczeń, w której urządzenia takie jak okulary AR czy zestawy słuchawkowe VR będą również przydatne w codziennym życiu, jak smartfony.

Autorzy projektu są przekonani, że widząc świat z perspektywy użytkownika, urządzenia będą mogły np. uczyć gry na bębnach, pomóc w przygotowaniu potrawy według przepisu, odnaleźć zgubione klucze, czy przywołać wspomnienia w postaci hologramów, które ożywają na oczach użytkownika. Systemy sztucznej inteligencji następnej generacji będą musiały uczyć się na podstawie zupełnie innego rodzaju danych – filmów, które pokazują świat z centrum akcji, a nie z boku.

Kluczowe wskaźniki

W projekcie Ego4D wzięło udział konsorcjum 13 uniwersytetów i laboratoriów z dziewięciu krajów. Dzięki wspólnym, wysiłkom udało się zebrać ponad 2,2 tys. godzin nagrań z życia codziennego ponad 700 uczestników.

To ma znacznie zwiększać skalę danych egocentrycznych, publicznie dostępnych dla społeczności badawczej. Facebook sfinansował projekt poprzez dotacje naukowe dla każdego z uczestniczących uniwersytetów.

Ponadto, we współpracy z konsorcjum i Facebook Reality Labs Research (FRL Research), badacze z Facebook AI opracowali pięć wskaźników referencyjnych, skupiających się na doświadczeniach wizualnych pierwszej osoby. Te wskaźniki mogą posłużyć jako podstawa do opracowania inteligentniejszych asystentów sztucznej inteligencji – takich, którzy potrafią zrozumieć i współdziałać nie tylko w świecie rzeczywistym, ale także w metaverse, gdzie rzeczywistość fizyczna, AR i VR łączą się w jednej przestrzeni. Oto one:

Pamięć epizodyczna: Sztuczna inteligencja może odpowiadać na dowolne pytania i rozszerzać pamięć osobistą użytkownika poprzez odzyskiwanie kluczowych momentów w przeszłych, egocentrycznych nagraniach wideo. Aby tego dokonać, model musi zlokalizować odpowiedź na zapytanie w obrębie poprzednich klatek wideo - a w razie potrzeby dodatkowo podać trójwymiarowe kierunki przestrzenne w środowisku. Jeśli więc przygotowujesz rodziców do pozostania z dziećmi, możesz zadać swojemu asystentowi AI lub robotowi domowemu pytania, takie jak „Gdzie zostawiłem ulubionego misia mojego dziecka?”.

Prognozowanie: Sztuczna inteligencja może zrozumieć, w jaki sposób działania użytkownika mogą wpłynąć na przyszły stan rzeczywistości, pod względem tego, gdzie dana osoba prawdopodobnie się poruszy, jakich przedmiotów prawdopodobnie dotknie lub w jaką czynność prawdopodobnie się zaangażuje.

Interakcja ręka-obiekt: Poznanie sposobu interakcji rąk z obiektami ma kluczowe znaczenie dla instruktażu w zakresie codziennych zadań. Sztuczna inteligencja musi wykrywać interakcje człowiek-przedmiot z pierwszej osoby, rozpoznawać chwyty i wykrywać zmiany stanu obiektu. Ten nacisk jest również motywowany uczeniem się robotów, które mogłyby zdobywać wiedzę, dzięki doświadczeniom ludzi obserwowanych na wideo.

Audiowizualna percepcja: Ludzie używają dźwięku, aby zrozumieć świat i zidentyfikować, kto co i kiedy powiedział. Sztuczna inteligencja przyszłości również ma to potrafić.

Interakcja społeczna: Poza rozpoznawaniem sygnałów wizualnych i dźwiękowych, kluczowym elementem inteligentnego asystenta SI ma być rozumienie interakcji społecznych. Inteligentna społecznie SI ma rozumieć, kto do kogo mówi i kto na kogo zwraca uwagę.

Chcemy być także bliżej Państwa – czytelników. Dlatego, jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected]. Przyszłość przynosi zmiany. Wprowadzamy je pod hasłem #CyberIsFuture.

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?