- WIADOMOŚCI

Deepfake w czasie wojny. Zaskakujące badanie

Fałszywe nagrania audio lub wideo zmodyfikowane przy pomocy sztucznej inteligencji mogą wpływać na rzeczywistość i zacierać granicę między tym, co realne a komputerowo zmienione. Najnowsze badania wykazały, że użytkownicy mediów społecznościowych, kiedy nie zgadzali się z jakimś materiałem… oznaczali go błędnie jako deepfake.

Autor. Inside Edition/ YouTube/ zrzut ekranu

Na łamach CyberDefence24 wielokrotnie pisaliśmy o zagrożeniu jakim są deepfake’i, czyli zmienione przy pomocy narzędzi opartych na głębokim uczeniu maszynowym materiały audio lub wideo. Wraz z rozwojem sztucznej inteligencji i dostępnością programów i aplikacji, które opierają się na AI, przygotowanie fałszywego materiału staje się właściwie dziecinnie proste i – co gorsza – często darmowe. Nie byłoby się czego obawiać, gdyby nie fakt, że tworzenie tego typu treści zwykle wiąże się z celem nadawcy: chęcią manipulacji czy oszukaniem odbiorcy.

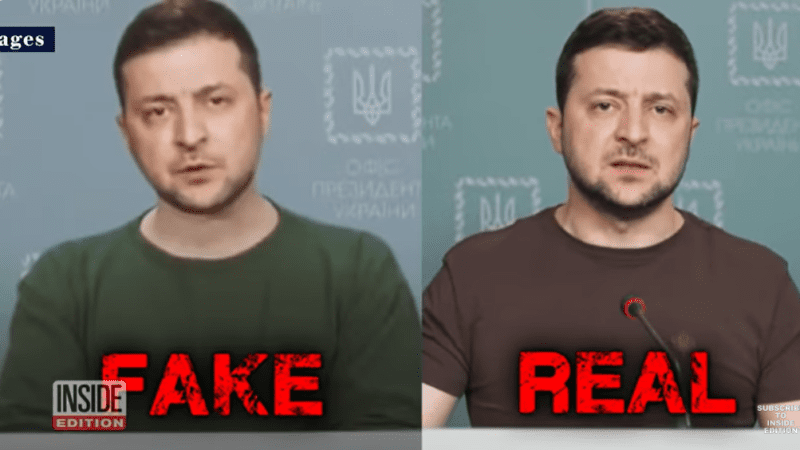

Najgroźniejszym jak do tej pory przykładem użycia deepfake’ów są te wyprodukowane w czasie wojny w Ukrainie, kiedy to zaledwie trzy tygodnie od rosyjskiej inwazji pojawiło się nagranie z prezydentem Wołodymyrem Zełenskim, rzekomo wzywającym do „złożenia broni”.

W krótkim czasie wyemitowano także wideo, na którym widać rzekomego prezydenta Rosji Władimira Putina, który ogłaszał „porozumienie pokojowe”. Choć Ukraina szybko zdementowała fejka, nagrania zostały udostępnione dziesiątki tysięcy razy, osiągając gigantyczne zasięgi.

Dało to jasny sygnał, że filmy zmodyfikowane przy pomocy najprostszego oprogramowania mogą służyć jako broń w czasie wojny, w ramach operacji psychologiczno-informacyjnych. Choć wskazane wyżej przykłady można było odróżnić gołym okiem (nienaturalne rysy twarzy, słaba jakość nagrania, nieprzystające do wypowiadanych słów ruchy warg itd.) to z pewnością nie brakowało osób, które uwierzyły w autentyczność obu wideo.

Zaskakujące badania

Ryzyko celowej manipulacji i wprowadzenia w błąd to jednak nie wszystko. Serwis Gizmodo powołuje się na nowe badania sugerujące na jeszcze jedno zagrożenie: wzrost liczby deepfake’ów i poczucie niepokoju, związanego z ich obecnością w sieci sprawia, że ludzie zaczynają utożsamiać autentyczne materiały z… deepfake’ami. To prowadzi do podważania zaufania i zatarcia się granic między tym, co prawdziwe, a tym co rzeczywiście zasługuje na miano fake newsa.

Badanie przeprowadzili naukowcy z Narodowego Uniwersytetu Irlandii w Cork, do analizy wybrali niemal 5 tys. wpisów na platformie X (dawniej Twitter), opublikowanych w ciągu pierwszych siedmiu miesięcy 2022 roku. Pod uwagę chcieli wziąć wpływ, jaki mają deepfake’i w czasie wojny na szerzenie się dezinformacji.

Celem badania miała być analiza tego, w jaki sposób dyskusje na temat deepfake«ów w czasie wojny i jak mogą wpływać na dzielenie się prawdą. Badacz pobrał (korzystając z API platformy X, jeszcze wtedy – Twitter) 4869 wpisów, omawiających deepfake’i (audio, wideo, zdjęcia) między 1 stycznia a 1 sierpnia 2022 roku. W tygodniach poprzedzających rosyjską inwazję wzrosła liczba treści związanych z fałszywymi wideo/audio - spekulowano wtedy na temat ich użycia w wojnie. Największa aktywność przypadła jednak na czas pojawienia się wspomnianych filmów z Zełenskim i Putinem – wtedy rozgorzała dyskusja o „nowej broni wojennej”.

Bardzo wiele z materiałów zostało rzeczywiście zmienionych przy pomocy narzędzi sztucznej inteligencji, jednak – jak określili badacze – „szokująca część wpisów rzekomo omawiających deepfake’i w rzeczywistości dotyczyła użytkowników fałszywie charakteryzujących prawdziwe, legalne obrazy i filmy jako cyfrowo zmienione”.

Nie zgadzasz się? "To deepfake"

Taki wniosek z kolei rodzi obawy, że wraz z coraz lepszą jakością fałszywych wideo i audio, efektem będzie podważanie jakichkolwiek filmów i podawanie argumentu, że „to deepfake”, aby go odrzucić. „Odkryliśmy, że ludzie używali terminu deepfake jako »modnego słowa« do atakowania innych osób w internecie” – skomentował badacz UCC School of Applied Psychology i współautor badania John Twomey, cytowany przez serwis Gizmodo.

Taki wniosek może nie być niczym zaskakującym, jeśli spojrzymy choćby na polską przestrzeń medialno-polityczną. Określenie „fake news” nie jest niestety używane tylko i wyłącznie w kontekście fałszywych wiadomości. Notorycznie nadużywają go wobec siebie oponenci, aby wyśmiać informację czy drugą osobę, z którą się nie zgadzają.

Czy ten sam los spotka deepfake? „To badanie podkreśla, w jaki sposób ludzie wykorzystują ideę deepfake«ów i stają się pod wieloma względami bardzo sceptyczni wobec prawdziwych mediów, zwłaszcza gdy deepfake’i nie są tak powszechne, jakby się to mogło wydawać” – ocenił John Twomey.

Liczy się efekt?

Badacz stawia też tezę, że ironią w ostrzeganiu przed fałszywymi wideo/audio może być wywołanie odwrotnego efektu od pożądanego i w rzeczywistości jeszcze obniżenie zaufania do mediów (i tak już będącego na bardzo niskim poziomie). Kwestią do rozważenia pozostają proporcje względem ostrzegania, w kontrze do realnego zagrożenia.

Jako przykład wykorzystania popularności deepfake’ów jako „broni”, by zdyskredytować realny problem serwis podał sprawę sądową jednej z osób, która brała udział w atakach na Kapitol 6 stycznia 2020 roku. Próbowano przekonać ławę przysięgłych, że materiał wideo „to deepfake”. Sąd nie dał się nabrać i skazał uczestniczącego w zamieszkach na 7 lat więzienia.

Nie wiesz, jak rozpoznać deepfake? Wskazówki znajdziesz w tym materiale.

Zobacz też

Serwis CyberDefence24.pl otrzymał tytuł #DigitalEUAmbassador (Ambasadora polityki cyfrowej UE). Jeśli są sprawy, które Was nurtują; pytania, na które nie znacie odpowiedzi; tematy, o których trzeba napisać – zapraszamy do kontaktu. Piszcie do nas na: [email protected].

Cyfrowy Senior. Jak walczy się z oszustami?